Una campagna di spionaggio “autonoma” è stata orchestrata dall’intelligenza artificiale

Un’analisi condotta negli ultimi mesi aveva evidenziato come l’evoluzione dei sistemi di intelligenza artificiale stesse raggiungendo un punto critico per la sicurezza informatica, con capacità raddoppiate in appena sei mesi.

Parallelamente, il monitoraggio degli attacchi reali mostrava un uso crescente dell’IA da parte degli attori malevoli. Ci si attendeva un progresso rapido, ma la velocità e la scala con cui si è manifestato hanno superato le previsioni.

A metà settembre 2025, un’attività anomala ha attirato l’attenzione dei ricercatori, rivelandosi in seguito una campagna di spionaggio di livello avanzato. Gli aggressori avevano adottato per la prima volta un impiego esteso delle funzioni “agentiche” dei modelli di IA, delegando loro l’esecuzione autonoma delle operazioni informatiche, non solo attività di supporto.

Le indagini hanno attribuito con elevato grado di sicurezza questa operazione a un gruppo collegato a interessi statali cinesi. L’autore della minaccia ha sfruttato in modo improprio Claude Code, trasformandolo in un componente del proprio framework offensivo, con il quale ha cercato di violare circa trenta bersagli nel mondo. In alcuni casi l’accesso è riuscito. Gli obiettivi includevano grandi aziende tecnologiche, istituti finanziari, imprese chimiche e agenzie governative. Si tratta, secondo gli analisti, del primo esempio documentato di attacco informatico su vasta scala condotto quasi interamente senza supervisione umana.

Una volta rilevata la campagna, sono state avviate verifiche immediate. Nei dieci giorni successivi, mentre venivano definite estensione e modalità operative dell’attacco, gli account compromessi sono stati progressivamente bloccati, le organizzazioni potenzialmente coinvolte informate quando opportuno e le autorità contattate per collaborare sull’indagine.

L’episodio evidenzia i rischi connessi alla diffusione degli “agenti” di IA: sistemi in grado di operare autonomamente a lungo, portare avanti compiti complessi e concatenare azioni senza un intervento umano costante. Tali strumenti sono preziosi per la produttività quotidiana, ma se sfruttati da un attore ostile possono amplificare la frequenza e l’impatto degli attacchi informatici.

Le previsioni indicano che la loro efficacia offensiva continuerà a crescere. Per contrastare questa tendenza, sono stati potenziati i sistemi di rilevamento e sviluppati nuovi classificatori per individuare rapidamente anomalie e azioni potenzialmente dannose. L’obiettivo è riuscire a identificare campagne distribuite e coordinate anche quando l’uso dell’IA rende meno evidente la presenza dell’operatore umano.

In attesa di progressi più ampi, il caso è stato reso pubblico per contribuire al rafforzamento delle difese nel settore privato, nella pubblica amministrazione e nella comunità scientifica. Secondo quanto dichiarato, verranno pubblicati ulteriori rapporti in futuro, nel segno della trasparenza sulle minacce emergenti.

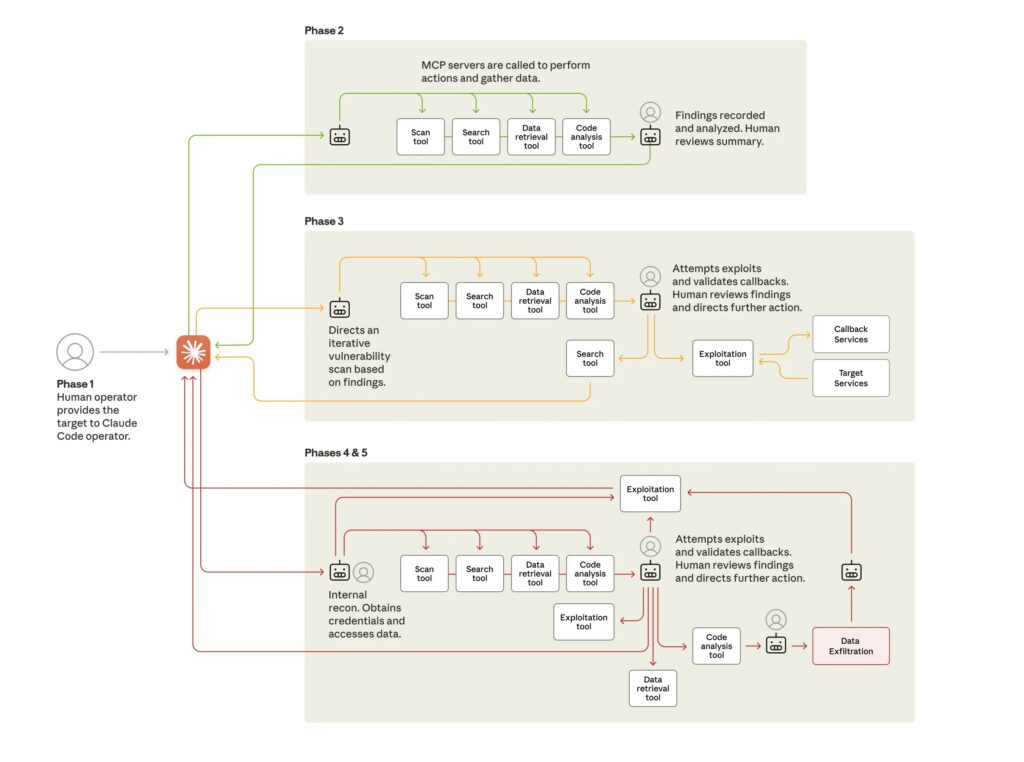

Come si è svolto l’attacco

La campagna ha sfruttato tre capacità dei modelli di IA che fino a un anno prima erano molto meno mature: un livello di intelligenza generale tale da interpretare istruzioni complesse; funzioni agentiche con cicli di azione autonoma; e un accesso diretto a strumenti software tramite protocolli standard come il Model Context Protocol (MCP), che permettono ricerche, recupero dati ed esecuzione di programmi.

Nella fase iniziale, gli operatori umani hanno selezionato i bersagli e predisposto un framework pensato per operare con minima supervisione. Questo sistema impiegava Claude Code come motore delle operazioni. Per farlo collaborare, gli aggressori lo hanno sottoposto a tecniche di jailbreak, aggirando i meccanismi di sicurezza. Hanno inoltre suddiviso l’operazione in compiti frammentati e presentati come legittimi test di sicurezza aziendale, in modo da impedirgli di coglierne la finalità complessiva.

Nella fase successiva, Claude Code ha effettuato la ricognizione dei sistemi delle organizzazioni prese di mira, individuando archivi e database sensibili. L’IA ha completato attività normalmente lunghe e complesse in tempi nettamente inferiori rispetto a un team umano, fornendo poi un riepilogo delle informazioni raccolte.

Il passo seguente ha riguardato l’individuazione delle vulnerabilità, la produzione del codice exploit e l’accesso alle prime credenziali. Il sistema ha quindi raccolto e classificato grandi quantità di dati, identificato account privilegiati, creato backdoor ed esfiltrato dati con un intervento umano marginale.

Nella fase conclusiva, l’IA ha generato la documentazione operativa: elenchi delle credenziali sottratte, mappe dei sistemi analizzati e altre informazioni utili per eventuali operazioni successive.

Secondo le stime, l’IA ha gestito tra l’80% e il 90% dell’intera campagna, con l’intervento umano limitato a pochi momenti decisionali. Il ritmo dell’attacco è risultato impossibile da eguagliare da operatori umani, grazie alla capacità di eseguire migliaia di richieste al secondo. Nonostante ciò, l’IA non si è dimostrata infallibile: in alcuni casi ha generato credenziali fittizie o segnalato come riservati dati già pubblici, ostacoli che limitano per ora l’automazione totale.

Le implicazioni per la sicurezza globale

L’episodio segna un cambiamento significativo. Le competenze richieste per condurre operazioni complesse diminuiscono, amplificando la possibilità che gruppi meno esperti o con risorse ridotte possano replicare attacchi simili. Rispetto ai casi di “vibe hacking” descritti mesi prima, il ruolo dell’essere umano è stato molto più marginale, pur in presenza di un’operazione più ampia e strutturata.

Gli stessi meccanismi che consentono a un modello di essere strumentalizzato in un attacco lo rendono, al contempo, un componente importante per la difesa. Funzionalità avanzate possono infatti supportare l’individuazione di minacce, la risposta agli incidenti e la preparazione contro varianti future degli stessi attacchi. Durante l’indagine, il team di Threat Intelligence ha utilizzato estensivamente Claude per analizzare l’enorme quantità di dati generati.

Di fronte a questa transizione, viene suggerito ai team di sicurezza di sperimentare l’uso controllato dell’IA per automatizzare parti del lavoro nei Security Operations Center, migliorare la rilevazione, testare vulnerabilità e ottimizzare le procedure di risposta. Parallelamente, agli sviluppatori viene raccomandato di investire in meccanismi di protezione più solidi per prevenire abusi da parte di attori ostili. Poiché tecniche simili saranno presumibilmente adottate in misura crescente, la condivisione tempestiva delle minacce e l’adozione di controlli più rigorosi diventano elementi centrali.

L'articolo Una campagna di spionaggio “autonoma” è stata orchestrata dall’intelligenza artificiale proviene da Red Hot Cyber.